Po co łączyć IoT z chmurą i kiedy to ma sens

IoT połączone z chmurą ma jeden nadrzędny cel: zbierać dane z wielu rozproszonych urządzeń, przetwarzać je centralnie i wykorzystywać do automatyzacji, predykcji i raportowania, bez budowania całej infrastruktury samodzielnie.

Integracja IoT z chmurą ma sens wszędzie tam, gdzie liczba urządzeń rośnie, dane muszą być dostępne globalnie, a system ma żyć i rozwijać się przez lata – nie jako jednorazowy projekt.

Typowe scenariusze użycia IoT z chmurą

Najczęstsze zastosowania integracji IoT z chmurą można sprowadzić do kilku grup funkcjonalnych.

Monitoring ciągły to klasyka: urządzenia wysyłają telemetrię do chmury, gdzie dane są wizualizowane, agregowane i alarmowane. Przykład: czujniki w fabryce raportują temperaturę, wibracje, zużycie energii; dashboard w chmurze pokazuje przekroczenia progów i generuje powiadomienia.

Predykcja i analityka, czyli użycie modeli ML/AI nad danymi IoT przechowywanymi w chmurze. Chmura jest tu wygodna, bo łatwo podłączyć narzędzia typu AWS SageMaker czy Azure Machine Learning, a dane historyczne trzymać w S3, Azure Data Lake lub bazach czasowych.

Zdalne sterowanie i konfiguracja obejmuje wysyłanie komend do urządzeń, zmiany ustawień, aktualizacje OTA. Chmura pełni rolę pośrednika: przyjmuje żądania z aplikacji biznesowych i rozsyła je do tysięcy urządzeń w polu.

Raportowanie biznesowe to łączenie danych IoT z systemami ERP, CRM, CMMS. Dane z czujników stają się podstawą raportów dla zarządu, rozliczeń serwisu czy SLA wobec klientów.

Korzyści z użycia chmury w projektach IoT

Integracja IoT z chmurą daje przewidywalne, powtarzalne korzyści, jeśli dobrze się ją zaprojektuje.

Skalowanie „w bok” pozwala zacząć od kilkudziesięciu urządzeń i dojść do dziesiątek tysięcy, nie zmieniając podstawowej architektury. AWS IoT Core i Azure IoT Hub są tworzone do obsługi dużej liczby połączeń równoległych, z automatycznym zarządzaniem infrastrukturą.

Gotowa analityka i integracje to dostęp do usług strumieniowania (AWS Kinesis, Azure Event Hub), funkcji bezserwerowych (Lambda, Functions), hurtowni danych i narzędzi BI (QuickSight, Power BI). Nie trzeba budować ETL ani API od zera.

Bezpieczeństwo w chmurze obejmuje: zarządzanie certyfikatami, monitorowanie logów, integrację z systemami IAM, compliance. Zarówno AWS, jak i Azure dają narzędzia do centralnej polityki bezpieczeństwa i audytu działań urządzeń.

Krótki czas wdrożenia wynika z gotowych usług: rejestracja urządzeń, broker MQTT, routing zdarzeń, bazy danych i dashboardy są dostępne „na kliknięcie”. Zespół może skupić się na logice biznesowej.

Kiedy IoT bez chmury ma sens

Nie każdy projekt IoT musi od razu korzystać z AWS IoT czy Azure IoT. Są sytuacje, gdzie architektura edge-only jest uzasadniona.

Systemy odcięte (air-gapped), np. infrastruktura krytyczna czy linie produkcyjne w środowiskach o najwyższych wymaganiach bezpieczeństwa, bywają całkowicie zamknięte na Internet i chmurę publiczną. Dane są gromadzone i analizowane lokalnie.

Aplikacje o skrajnie niskich opóźnieniach, gdzie decydują milisekundy, częściej bazują na lokalnym edge (np. AWS IoT Greengrass czy Azure IoT Edge zlokalizowane na bramce) i tylko okresowo synchronizują się z chmurą lub wcale.

Proste, małe wdrożenia z ograniczonym budżetem, gdzie jest kilka–kilkanaście urządzeń w jednym miejscu, mogą użyć lokalnego serwera MQTT i prostego zapisu do bazy na Raspberry Pi lub serwerze on-premises. Chmura bywa wtedy przerostem formy nad treścią.

Czego realnie oczekiwać od platformy chmurowej IoT

Wybierając między AWS IoT a Azure IoT, decyzję warto oprzeć na kilku kryteriach funkcjonalnych i kosztowych.

Niezawodność: wymagane SLA, zachowanie przy utracie łączności, mechanizmy kolejkowania i buforowania wiadomości. Obie platformy zapewniają wysoką dostępność, ale różnią się detalami implementacji.

Przewidywalność kosztów: model rozliczeń za wiadomości, operacje, przechowywanie danych, transfer i dodatkowe usługi (funkcje, bazy, analityka). Trzeba umieć przeliczyć scenariusz: liczba urządzeń × komunikaty × rozmiar danych.

Czas wdrożenia: dostępność gotowych integracji, szablonów referencyjnych, SDK dla konkretnych języków i systemów. Microsoft mocno stawia na scenariusze i wzorce, AWS na elastyczne „klocki” do złożenia własnego rozwiązania.

Integracja z istniejącym ekosystemem IT: jeśli firma korzysta szeroko z Azure AD, Office 365, Dynamics, często naturalnym wyborem jest Azure IoT; jeśli dominują systemy zbudowane wcześniej na AWS – przewagę ma AWS IoT.

Elementy typowej architektury IoT z chmurą

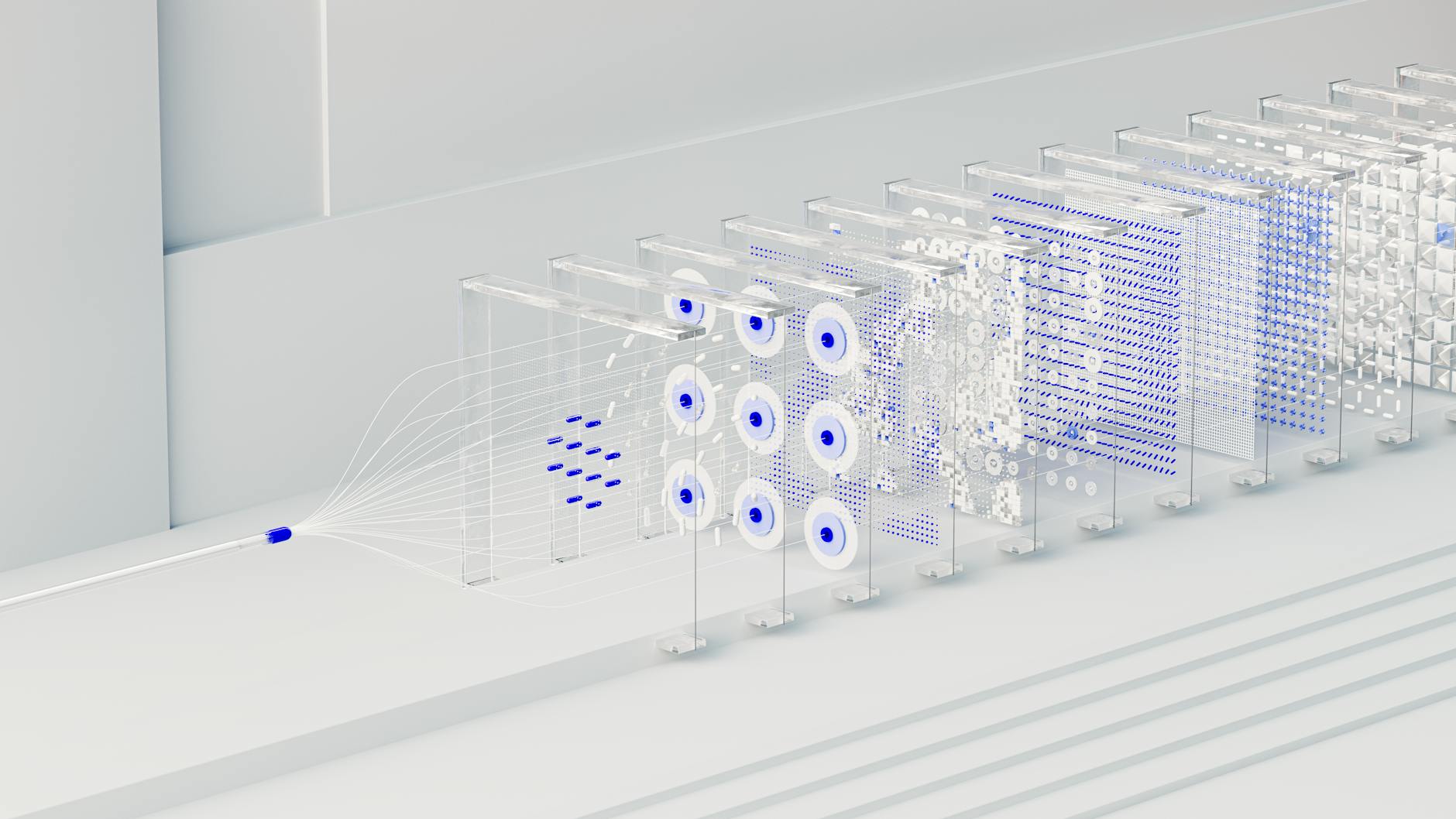

Architektura IoT z chmurą da się najczęściej rozpisać na łańcuch: urządzenie → bramka (edge) → chmura IoT → usługi chmurowe → aplikacje biznesowe.

Urządzenia, bramki i warstwa komunikacji

Na dole architektury są urządzenia końcowe: sensory, sterowniki PLC, liczniki, sterowniki HVAC, urządzenia mobilne. To one generują telemetrię, odczyty, alarmy.

Bezpośrednie podłączenie do chmury (np. przez MQTT over TLS) ma sens, gdy urządzenie ma wystarczające zasoby (CPU, RAM, TLS), stabilne łącze IP i nie jest ich bardzo wiele w jednym miejscu lokalnym.

Bramki (gateway, edge) pośredniczą między prostymi urządzeniami (Modbus, CAN, BLE, Zigbee, LoRa) a chmurą. Realizują:

- agregację danych z wielu urządzeń w jedną sesję do chmury,

- konwersję protokołów lokalnych na MQTT/HTTPS/AMQP,

- wstępne filtrowanie, kompresję i buforowanie danych,

- lokalną logikę sterowania na wypadek utraty łączności z chmurą.

Sieć łącząca edge z chmurą to zwykle LTE/5G, Ethernet lub Wi-Fi z dostępem do Internetu. Kluczowe są: stabilność, opóźnienia, koszty transferu i wymagania bezpieczeństwa (np. VPN, TLS, firewall).

Warstwa chmurowa i systemy biznesowe

Chmura dla IoT to nie tylko IoT Core/Hub. To cały łańcuch usług potrzebnych do zebrania, obróbki i udostępnienia danych.

Warstwa IoT w chmurze (AWS IoT Core, Azure IoT Hub) odpowiada za:

- utrzymanie połączeń z urządzeniami (MQTT, HTTPS, AMQP),

- uwierzytelnienie i autoryzację urządzeń,

- odbiór telemetrii i dostarczanie komend,

- mechanizmy device twin/shadow,

- podstawowy routing wiadomości do kolejnych usług.

Za IoT Core/Hub stoją usługi przetwarzania: kolejki i strumienie (Kinesis, Event Hub), funkcje bezserwerowe (Lambda, Functions), kontenery, a dalej bazy danych (DynamoDB, Cosmos DB, Timestream, SQL), storage obiektowy (S3, Blob Storage) i narzędzia analityczne (Athena, Synapse, Data Explorer, Power BI).

Na samej górze są aplikacje biznesowe: panele webowe, mobilne, integracje z ERP/CRM, systemy serwisowe, raportowanie zarządcze. Często komunikują się one z chmurą IoT pośrednio, przez API i bazy danych, a nie bezpośrednio z IoT Core/Hub.

Protokoły komunikacyjne: MQTT, HTTP/REST, AMQP

Protokół komunikacji między urządzeniami a chmurą to jedno z kluczowych wyborów w projekcie.

MQTT jest lekkim, dwukierunkowym protokołem publikacja/subskrypcja, idealnym dla IoT. AWS IoT Core i Azure IoT Hub obsługują MQTT z TLS, z różnymi poziomami QoS. MQTT jest dobry do:

- ciągłej telemetrii o umiarkowanej częstotliwości,

- zdalnych komend,

- scenariuszy, gdzie urządzenia często zmieniają IP, ale utrzymują sesję.

HTTP/REST sprawdza się w projektach, gdzie urządzenia budzą się rzadko, wysyłają porcję danych i zasypiają (np. liczniki bateryjne). Łatwo go zaimplementować, gorzej z dwukierunkowością i push-em ze strony chmury.

AMQP jest częściej używany po stronie serwerowej, do integracji usług w chmurze. Azure IoT Hub bazuje wewnętrznie na Event Hub / AMQP, ale urządzenia końcowe zwykle używają MQTT lub HTTPS.

Przepływ danych: telemetria, komendy, konfiguracja, OTA

Pełny przepływ danych w platformie IoT z chmurą to coś więcej niż wysłanie temperatury co minutę.

Telemetria to dane wysyłane z urządzeń do chmury: pomiary, alarmy, logi serwisowe. Są zapisywane w hurtowniach, bazach czasowych, używane w analityce i raportach.

Komendy zwrotne to polecenia z chmury do urządzeń: zmiana nastawy, restart, uruchomienie procedury kalibracji. Często idą przez MQTT (topics komend) albo indirektnie przez device twin/shadow.

Konfiguracja i device twin/shadow przechowują stan pożądany i raportowany urządzeń. Zmiana stanu pożądanego w chmurze powoduje, że urządzenie synchronizuje się i lokalnie aktualizuje konfigurację.

Aktualizacje OTA (Over-The-Air) to ważny element bezpieczeństwa: nowe wersje firmware, łatki bezpieczeństwa, zmiany konfiguracji globalnych. AWS i Azure mają osobne mechanizmy do planowania, dystrybucji i monitorowania OTA.

Przegląd AWS IoT – główne usługi i podejście

AWS traktuje IoT jako zestaw elastycznych klocków do budowy własnych rozwiązań. Integracja IoT z chmurą AWS opiera się na usługach typu event-driven.

Kluczowe komponenty platformy AWS IoT

Trzon platformy to AWS IoT Core. Odpowiada za połączenia MQTT/HTTPS, uwierzytelnianie urządzeń, routing wiadomości na podstawie reguł i mechanizm Device Shadow.

AWS IoT Device Management pomaga w masowym zarządzaniu urządzeniami: rejestrowanie, grupowanie, inwentaryzacja, aktualizacje OTA, rollout według grup i monitorowanie postępu.

AWS IoT Analytics i AWS IoT Events dodają wyższy poziom logiki: przetwarzanie strumieni danych, definiowanie warunków alarmowych, wykrywanie anomalii i integrację z analityką bardziej zaawansowaną.

AWS IoT Greengrass przenosi część funkcji chmurowych na edge. Umożliwia uruchamianie funkcji Lambda lokalnie, buforowanie komunikatów, filtrowanie danych oraz pracę offline, z okresową synchronizacją.

Dla danych czasowych AWS oferuje Amazon Timestream – bazę zoptymalizowaną pod dane telemetryczne. Do długoterminowego archiwum można wykorzystać S3, a do zapytań ad-hoc – Amazon Athena.

Integracja usług IoT z resztą ekosystemu AWS

Siła AWS IoT Core wynika z łatwej integracji z innymi usługami AWS.

Reguły AWS IoT (IoT Rules Engine) pozwalają na zdefiniowanie, co zrobić z każdą przychodzącą wiadomością: zapisać do DynamoDB lub Timestream, wysłać do Kinesis, opublikować do SNS, wywołać funkcję Lambda.

Funkcje AWS Lambda to naturalne miejsce na lekką logikę biznesową: walidacja danych, wzbogacanie metadanymi, routing do różnych baz, detekcja prostych zdarzeń.

Strumienie danych i kolejki (Kinesis, SQS, SNS) służą do budowy skalowalnych pipeline’ów danych. Pozwalają oddzielić warstwę przyjmowania danych IoT od analityki, batchy i integracji z zewnętrznymi systemami.

Dane z IoT można następnie trzymać w DynamoDB (klucze urządzenie+czas), Timestream (serie czasowe), Relational Database Service (raporty relacyjne) lub S3 (hurtownia danych, archiwum).

Model projektowania rozwiązań IoT w AWS

AWS promuje podejście event-driven. IoT Core generuje zdarzenia (wiadomości MQTT, zmiany shadow, zdarzenia connecting/disconnecting), a kolejne usługi reagują na te zdarzenia.

Buduje się z tego łańcuchy: urządzenie publikuje telemetrię → reguła IoT zapisuje do bazy i/lub wywołuje funkcję Lambda → Lambda ewentualnie publikuje kolejną wiadomość lub aktualizuje device shadow.

Elastyczność jest wysoka, ale wymaga dobrej dyscypliny architektonicznej. Brak „gotowego rozwiązania” oznacza większą swobodę, ale i większą odpowiedzialność za spójność całości.

Przykładowy przepływ danych w AWS IoT

Naturalny przykład to proste monitorowanie maszyn.

Urządzenie przemysłowe (lub bramka) łączy się z AWS IoT Core przez MQTT over TLS, uwierzytelnione certyfikatem X.509. Publikuje co 10 sekund wiadomość na topicu np. factory/line1/machine42/telemetry.

W IoT Core istnieje reguła: jeśli przychodzi wiadomość na ten topic, dane są zapisywane do Timestream (z tagiem urządzenia) oraz jednocześnie przekazywane do funkcji Lambda.

Funkcja Lambda sprawdza, czy temperatura przekracza próg. Jeśli tak – publikuje na topicu alarmowym (np. factory/line1/alarms) oraz wysyła powiadomienie e-mail/SMS przez Amazon SNS.

Dodatkowo dane są kopiowane do S3, by móc wykonywać szerszą analitykę offline w Amazon Athena lub narzędziach BI.

Przegląd Azure IoT – główne usługi i podejście

Usługi budujące platformę Azure IoT

Rdzeniem platformy Microsoftu jest Azure IoT Hub. Utrzymuje połączenia z urządzeniami, zarządza tożsamością, odbiera telemetrię i udostępnia mechanizmy chmurowego bliźniaka urządzenia (device twin).

Azure IoT Hub Device Provisioning Service (DPS) automatyzuje proces dołączania dużej liczby urządzeń. Pozwala na bezdotykową rejestrację (zero-touch provisioning) z użyciem certyfikatów lub TPM.

Azure IoT Edge umożliwia przeniesienie części przetwarzania na bramki i komputery brzegowe. Kontenery z logiką (moduły) są zarządzane centralnie z chmury, ale wykonują się lokalnie, blisko danych.

Dla danych telemetrycznych Microsoft oferuje kilka ścieżek: Event Hubs / Event Hub compatible endpoint w IoT Hub, potem Azure Stream Analytics, Azure Functions, a na końcu bazy (Cosmos DB, Azure Data Explorer, Azure SQL, Data Lake Storage).

Azure Digital Twins dodaje warstwę modelowania świata fizycznego: budynków, maszyn, pomieszczeń. Pozwala łączyć dane z wielu urządzeń w spójne modele obiektów i relacji.

Integracja Azure IoT z resztą platformy Azure

IoT Hub wystawia tzw. endpoints, na które kieruje zdarzenia. Najczęściej są to Event Hubs, Service Bus, Functions lub bezpośrednio Stream Analytics.

Azure Stream Analytics jest prostym narzędziem do przetwarzania strumieniowego w SQL-like. Umożliwia filtrowanie, agregacje w oknach czasowych, joiny z danymi referencyjnymi, a wynik kieruje do Power BI, bazy, kolejki lub innej usługi.

Azure Functions pełnią podobną rolę jak AWS Lambda. Nadają się do lekkiej logiki reagującej na nowe komunikaty, zmiany twinów, alarmy. Łatwo je wywołać z IoT Hub lub Event Hub.

Dalej dane lądują zwykle w Azure Data Lake Storage (hurtownia plikowa), Azure Synapse Analytics (analityka i raportowanie), Azure Data Explorer (zapytania nad danymi czasowymi) lub Cosmos DB (operacyjne API z niskimi opóźnieniami).

Warstwa wizualizacji to głównie Power BI, ale też aplikacje webowe hostowane w App Service lub statyczne frontendy w Azure Static Web Apps, korzystające z API wystawionego przez Functions lub Web Apps.

Typowy sposób projektowania rozwiązań w Azure IoT

Microsoft kładzie nacisk na gotowe wzorce integracyjne i wykorzystanie znanych klocków: Event Hub, Service Bus, Stream Analytics, Power BI.

Częsty schemat: urządzenie publikuje do IoT Hub → wiadomość trafia na endpoint kompatybilny z Event Hub → Stream Analytics przetwarza i zapisuje do bazy lub Data Lake → Power BI używa tego jako źródła.

Mocnym elementem jest integracja z Active Directory i narzędziami zarządzania tożsamością użytkowników oraz rozbudowane SDK do C#, .NET, Pythona, Node.js.

Przykładowy przepływ danych w Azure IoT

Prosty przykład to monitoring zużycia energii w budynku.

Liczniki energii lub bramka zbierająca dane łączą się z Azure IoT Hub przez MQTT/HTTPS, używając kluczy symetrycznych lub certyfikatów X.509. Co minutę wysyłają agregaty energii na dedykowany endpoint.

W IoT Hub skonfigurowany jest endpoint Event Hub compatible. Azure Stream Analytics czyta z niego strumień danych, liczy średnie i sumy w oknach 15-minutowych, a wyniki zapisuje do Azure SQL lub Azure Data Explorer.

Power BI łączy się z bazą i pokazuje zużycie energii per piętro, per linia produkcyjna czy per zmiana. Alerty powstają z reguł w Stream Analytics (np. przekroczenie mocy umownej) lub w samym Power BI.

Porównanie AWS IoT Core i Azure IoT Hub w praktyce

Porównanie platform warto oprzeć na konkretnych pytaniach: jakie protokoły, jakie limity, jak działa routing, co z offline, jak wygląda obsługa OTA i twinów.

Protokoły i modele komunikacji

Obie platformy obsługują MQTT, HTTPS i komunikację dwukierunkową. AWS IoT Core prostolinijnie eksponuje MQTT topics. Azure IoT Hub opiera się na logicznym modelu wiadomości do i z urządzeń.

W AWS IoT Core każda wiadomość MQTT ma topic, po którym filtruje ją IoT Rules Engine. Jest to bardzo elastyczne, dobrze pasuje do projektów, które już korzystają z MQTT on-premise.

W Azure IoT Hub topics MQTT są pod spodem, ale warstwa aplikacyjna widzi głównie „telemetry”, „device-to-cloud” i „cloud-to-device messages” oraz twin i direct methods. To z kolei ułatwia życie zespołom, które nie chcą projektować własnych struktur topiców.

Routing wiadomości i integracja z innymi usługami

AWS IoT Rules Engine pozwala bezpośrednio kierować dane do wielu usług (DynamoDB, S3, Lambda, Kinesis). Definiuje się SQL-like reguły na topicach, można stosować proste transformacje.

Azure IoT Hub używa tzw. message routing. Ustawia się warunki (na właściwościach wiadomości) i kieruje się zdarzenia na konkretne endpoints (Event Hubs, Service Bus, Storage). Transformacje zwykle wykonuje się już w Stream Analytics lub Functions.

W praktyce AWS ma bardziej „wbudowany” mechanizm routingu na poziomie IoT, Azure częściej wymaga dołożenia jeszcze jednego komponentu (Stream Analytics/Functions) do prostszych scenariuszy transformacji.

Device twin/shadow i praca offline

AWS oferuje Device Shadow, Azure – Device Twin. Obie funkcje przechowują stan pożądany i raportowany urządzenia oraz różnice między nimi.

W AWS Device Shadow jest ściśle zintegrowany z MQTT. Urządzenie subskrybuje odpowiednie topics i aktualizuje stan przy każdej zmianie. To podejście jest bardzo „MQTT-native”.

W Azure Device Twin jest bardziej neutralny protokołowo. Zmiany twinów są obsługiwane przez SDK, a logika jest podobna: zmiana stanu w chmurze → urządzenie pobiera nowy desired state, aktualizuje konfigurację i raportuje reported state.

Co do pracy offline, przewagę daje IoT Greengrass i Azure IoT Edge. AWS Greengrass mocno stawia na funkcje Lambda i integrację z usługami AWS-on-edge. Azure IoT Edge buduje wszystko na kontenerach i modułach, co lepiej współgra z istniejącym środowiskiem Docker/Kubernetes w firmie.

Obsługa OTA i masowe zarządzanie urządzeniami

W AWS aktualizacje OTA i zarządzanie flotą zapewnia głównie AWS IoT Device Management. Definiuje się zadania aktualizacji (jobs), wybiera grupy urządzeń, kontroluje rollout i monitoruje statusy.

Azure oferuje podobne możliwości przez IoT Hub Device Management oraz dodatkowe usługi jak Azure Device Update for IoT Hub. OTA jest realizowane zwykle przez moduły na Azure IoT Edge lub logikę wbudowaną w firmware urządzeń korzystających z IoT Hub.

W obu przypadkach kluczowy jest własny proces DevOps dla firmware: wersjonowanie, testy na małej grupie, zarządzanie wycofaniem aktualizacji. Platforma chmurowa daje narzędzia, ale nie zastąpi procedur organizacyjnych.

Limity, skalowanie i dostępność

Obie platformy deklarują liniowe skalowanie do milionów urządzeń. Różnice pojawiają się w szczegółowych limitach: liczba komunikatów na sekundę, maksymalna wielkość wiadomości, liczba połączeń na instancję.

W AWS IoT Core skalowanie odbywa się automatycznie, ale część limitów jest miękko egzekwowana i wymaga podniesienia przez support dla bardzo dużych wdrożeń.

Azure IoT Hub stosuje jednostki SKU (np. S1, S2) z określonym limitem komunikatów na dzień i na sekundę. Skalowanie polega na zwiększeniu liczby jednostek w danym SKU, co daje przewidywalne koszty, ale wymaga planowania.

W praktyce oba podejścia się sprawdzają. Na etapie projektowania trzeba po prostu policzyć szczytową ilość komunikatów i dobrać odpowiedni rozmiar planu (Azure) lub uzgodnić limity (AWS).

Bezpieczeństwo i tożsamość urządzeń w AWS i Azure

Bezpieczna identyfikacja i komunikacja urządzeń to fundament. Różnice między chmurami są subtelne, ale mają wpływ na projekt firmware i procesu produkcyjnego.

Modele uwierzytelniania urządzeń

AWS IoT Core stawia na certyfikaty X.509 jako główny mechanizm uwierzytelniania. Każde urządzenie ma własny certyfikat powiązany z „thing” w IoT Registry.

Azure IoT Hub oferuje trzy główne opcje: klucze symetryczne (SAS tokens), certyfikaty X.509 per urządzenie oraz integrację z TPM. Klucze symetryczne są prostsze w implementacji, ale słabsze od strony bezpieczeństwa długoterminowego.

W projektach o wyższych wymaganiach (przemysł, energetyka) rozsądnie jest zakładać certyfikaty X.509 po obu stronach, z własnym CA lub użyciem HSM/TPM na urządzeniach.

Provisioning i rotacja kluczy

W AWS początkowe provisionowanie certyfikatów może odbywać się na linii produkcyjnej (wypalanie certyfikatów) lub przez Just-in-Time Provisioning / Just-in-Time Registration z użyciem zaufanego CA.

Azure DPS automatyzuje mapowanie urządzeń do konkretnych IoT Hubów na podstawie certyfikatu lub identyfikatora. Sprawdza się to przy bardzo dużych flotach rozproszonych po wielu regionach lub tenantach.

Rotacja kluczy i certyfikatów wymaga przemyślenego mechanizmu w firmware. Chmura daje API do generowania nowych kluczy, ale to urządzenie musi umieć je bezpiecznie pobrać, zapisać i zacząć używać bez przerwy w pracy.

Autoryzacja, polityki i kontrola dostępu

W AWS uprawnienia urządzeń definiuje się przez IAM policies przypięte do certyfikatów. Można bardzo dokładnie kontrolować, jakie topics może publikować/odbierać dane urządzenie.

Azure IoT Hub używa zasad dostępu na poziomie IoT Hub (shared access policies) oraz scope’ów per urządzenie. Granularność jest inna, ale efekt podobny: ograniczenie zakresu operacji i kanałów komunikacji.

Po stronie użytkowników i aplikacji biznesowych Azure mocno korzysta z Azure Active Directory, podczas gdy AWS z AWS IAM i integracji z zewnętrznymi IdP. Wybór ma znaczenie, jeśli firma ma już centralny system tożsamości.

Szyfrowanie, sieć i zgodność

Połączenia urządzenie–chmura są szyfrowane TLS w obu platformach. S3, Blob Storage, bazy danych – wszystko można (i zazwyczaj domyślnie się) szyfruje at-rest.

Na poziomie sieci można stosować prywatne endpoints, VPN lub dedykowane łącza (AWS Direct Connect, Azure ExpressRoute), jeśli urządzenia komunikują się z chmurą z sieci korporacyjnej, a nie z publicznego Internetu.

Oba środowiska mają szeroki zakres certyfikacji (ISO, SOC, branżowe), ale przy projektach regulowanych (np. medycyna, energetyka) trzeba sprawdzić konkretne wymagania i dostępność regionów spełniających dane normy.

Przykładowa architektura referencyjna prostego systemu IoT

Dla porównania warto spojrzeć na mały, ale realistyczny scenariusz i zbudować jego wersję w AWS i w Azure.

Założenia systemu: monitorowanie środowiska w budynku

Scenariusz: monitoring temperatury, wilgotności i jakości powietrza w biurze lub hali. Kilkadziesiąt czujników rozmieszczonych na piętrach, kilka bramek edge, dashboard dla zespołu utrzymania budynku.

Wymagania funkcjonalne:

- telemetria co 30–60 sekund z każdego czujnika,

- podstawowe alarmy (za wysoka temperatura, za niska jakość powietrza),

- możliwość zmiany konfiguracji czujników (np. interwał wysyłania),

- prosta aktualizacja firmware przez OTA,

- panel webowy z wykresami historycznymi i statusem online/offline.

Założenia techniczne:

- czujniki korzystają z protokołu np. Modbus lub BLE,

- bramka edge ma dostęp do Internetu przez LTE lub Ethernet,

- organizacja używa już Office 365 / Azure AD (scenariusz Azure) lub ma większość systemów w AWS (scenariusz AWS).

Architektura w AWS – wariant referencyjny

Czujniki łączą się lokalnie z bramką (np. mini PC z Linuxem i AWS IoT Greengrass). Bramka agreguje dane, filtruje je i co kilkadziesiąt sekund publikuje telemetrię do AWS IoT Core przez MQTT.

W AWS IoT Core skonfigurowane są:

- registry „things” dla bramek i czujników (czujniki mogą być reprezentowane logicznie jako oddzielne things),

- Device Shadows dla każdej bramki i/lub czujnika (przechowywanie konfiguracji),

- polityki IoT ograniczające topics, do których mają dostęp urządzenia.

Rules Engine kieruje telemetrię do dwóch miejsc:

- Amazon Timestream – główne źródło danych czasowych dla panelu,

- Lambda – prosty kod wykrywający przekroczenia progów i generujący alarmy.

Lambda przy alarmie:

- publikuje komunikat na topicu alarmowym dla bramki (np. zapalenie lokalnej diody, wysłanie sygnału do systemu BMS),

- wysyła powiadomienie do SNS (e-mail/SMS) lub zapisuje zdarzenie do DynamoDB jako log alarmów.

Front webowy działa w AWS Amplify lub na S3+CloudFront. Korzysta z API wystawionego przez Amazon API Gateway + Lambda, które czyta dane z Timestream / DynamoDB i zwraca je w formie wygodnej dla UI.

OTA dla bramek jest realizowane przez AWS IoT Device Management. Firmware jest trzymany w S3, joby aktualizacji planuje się na grupy bramek, z kontrolą rollout-u.

Architektura w Azure – wariant referencyjny

Układ urządzeń jest podobny: czujniki lokalne, bramki edge z Azure IoT Edge. Moduły na IoT Edge zbierają dane, mogą wykonywać wstępne agregacje i wysyłają je batched do IoT Hub.

W Azure IoT Hub skonfigurowane są:

- rejestr urządzeń z twinami (device twins) dla bramek i czujników,

- grupy urządzeń i tagi służące do segmentacji flot (np. piętro, strefa, typ pomieszczenia),

- zasady routingu wiadomości (message routing) do usług przetwarzania.

Routing IoT Hub kieruje dane m.in. do:

- Azure Data Explorer lub Time Series Insights – analiza szeregów czasowych i wykresy,

- Azure Functions lub Azure Stream Analytics – wykrywanie przekroczeń progów i prosta logika.

Funkcje lub zapytania Stream Analytics przy alarmie:

- publikują komunikat do IoT Hub jako cloud-to-device (reakcja bramki),

- zapisują zdarzenia do Cosmos DB lub Table Storage jako dziennik incydentów,

- mogą wyzwalać akcje w Logic Apps (e-mail, Teams, integracje z systemem BMS).

Front webowy zwykle działa w Azure App Service lub Static Web Apps. Backend API korzysta z Azure Functions / App Service i czyta dane z Data Explorer / Cosmos DB. Uwierzytelnianie oparte o Azure AD dobrze współgra z Office 365.

Aktualizacje OTA dla bramek realizuje się przez Azure IoT Edge (deploymenty modułów) albo Azure Device Update for IoT Hub. Obrazy modułów są trzymane w Azure Container Registry, a firmware w Blob Storage.

Porównanie wariantów referencyjnych

W obu środowiskach przepływ jest podobny: urządzenie → hub → przetwarzanie zdarzeń → baza czasowa → aplikacja. Różni się „smak” usług i model zarządzania.

- W AWS mocniej wykorzystuje się Lambda i menedżer usług zarządzanych (Timestream, DynamoDB).

- W Azure dużo łatwiej spiąć tożsamość użytkowników z Azure AD i narzędziami biurowymi.

Przy małym systemie decyzja rzadko zależy od samych możliwości IoT. Decyduje to, gdzie są już dane firmowe, jaki zespół ma doświadczenia i jak wyglądają procesy bezpieczeństwa.

Koszty AWS IoT i Azure IoT – składowe, o których trzeba pamiętać

Koszty IoT w chmurze to nie tylko hub (IoT Core / IoT Hub). Często większą część rachunku generują usługi „wokół”.

Główne kategorie kosztów w projektach IoT

Niezależnie od dostawcy zwykle pojawiają się te same kategorie:

- komunikacja urządzeń (połączenia, wiadomości, operacje na twinach/shadows),

- przetwarzanie zdarzeń (Lambda, Functions, Stream Analytics itp.),

- przechowywanie danych (bazy czasowe, hurtownie, obiekty),

- transfer danych (między usługami, z/na Internet),

- usługi dodatkowe (Device Management, DPS, security, monitoring).

Przy małych wdrożeniach różnice liczone są w dziesiątkach dolarów miesięcznie. Przy setkach tysięcy urządzeń będą już krytyczne.

Model kosztowy AWS IoT Core – w skrócie

AWS IoT Core rozlicza się głównie za:

- ilość komunikatów (requestów) – limitowane rozmiarem payloadu,

- operacje na Device Shadows,

- połączenia i czas utrzymywania sesji (w ograniczonym zakresie),

- wykorzystanie dodatkowych funkcji (np. greengrass, jobs) w innych usługach.

Do tego dochodzą:

- wywołania Lambda (liczba i czas wykonywania),

- Timestream (zapisy, odczyty, retention),

- S3 (przechowywanie firmware, logów i archiwów),

- transfer wychodzący z regionu (np. do Internetu, innych regionów).

Przy ruchu telemetrycznym liczy się łączna liczba wiadomości na urządzenie na dobę. Nawet niewielka zmiana częstotliwości raportowania lub wielkości payloadu może wielokrotnie zmienić koszt.

Model kosztowy Azure IoT Hub – w skrócie

Azure IoT Hub działa na SKU i jednostkach, co zmienia sposób planowania.

- Wybiera się plan (np. S1, S2) z określoną liczbą komunikatów dziennie.

- Dokupuje się jednostki w ramach tego planu, jeśli potrzeba większej przepustowości.

- Limit obejmuje zarówno device-to-cloud, jak i cloud-to-device.

Dalej dochodzą usługi:

- Stream Analytics lub Functions do przetwarzania,

- Data Explorer, Time Series Insights, Cosmos DB lub SQL/Blob Storage do przechowywania,

- Device Provisioning Service (DPS), jeśli korzysta się z automatycznego provisioningu,

- Application Insights / Monitor do logowania i metryk.

Tak jak w AWS, liczy się suma komunikatów i rozmiar danych. Różnica polega na tym, że IoT Hub można w miarę przewidywalnie „dociążyć” kolejnymi jednostkami zamiast liczyć każdy request osobno.

Jak policzyć orientacyjny koszt – przykład ilościowy

Przykład oparty o opisany wcześniej system w budynku:

- 50 czujników raportuje co 60 sekund,

- komunikacja idzie przez 5 bramek, które pakują dane w jeden komunikat na 10 sekund,

- payload po kompresji ma kilka kilobajtów.

Otrzymujemy kilkaset komunikatów na minutę, czyli kilkaset tysięcy dziennie. W obu chmurach zmieści się to w niższych progach cenowych czy niewielkiej liczbie jednostek IoT Hub.

Jeśli jednak każdy czujnik zacznie wysyłać dane bezpośrednio co 5 sekund, liczba komunikatów wzrośnie o rząd wielkości. Często taniej jest inwestować w agregację na edge niż w większy plan chmurowy.

Różnice kosztowe: kiedy AWS, kiedy Azure bywa tańszy

Nie da się uczciwie powiedzieć, że jedna platforma jest „tańsza zawsze”. Dużo zależy od wzorca obciążenia i dobranych usług.

- Jeśli przetwarzanie opiera się głównie na zdarzeniach i krótkich funkcjach, AWS Lambda może wyjść korzystnie, zwłaszcza przy nieregularnym ruchu.

- Jeśli firma już intensywnie korzysta z Azure (hurtownie, AD, monitoring), to łączny koszt integracji i administracji będzie niższy po stronie Azure, nawet gdy same jednostkowe ceny za komunikaty są podobne.

- Projekty z dużym wolumenem danych historycznych czasowych często korzystają z wyspecjalizowanych usług (Timestream vs Data Explorer) – ich modele cenowe są różne i trzeba je porównać pod kątem liczby zapisów i retencji.

Przy bardziej skomplikowanych systemach (np. wiele regionów, przetwarzanie near-real-time, raporty BI) kluczowe są rabaty, umowy enterprise i rezerwacje zasobów – to ma większy wpływ niż same cenniki publiczne.

Typowe błędy przy szacowaniu kosztów IoT w chmurze

Szacowanie „na oko” zwykle kończy się niedoszacowaniem kilku elementów.

- Niedoliczenie komunikatów pomocniczych – twin/shadow, heartbeaty, aktualizacje konfiguracji.

- Brak założeń o ruchu cloud-to-device (komendy, OTA, potwierdzenia), który też jest liczony.

- Pominięcie kosztów logowania i monitoringu – metryki, logi, trace potrafią stanowić istotną część rachunku.

- Brak planu retencji – dane telemetryczne „na zawsze” w drożejących usługach przechowywania.

- Zbyt szczegółowa granularność danych – wysyłanie każdej próbki zamiast agregatów (średnia, min/max).

Przy pierwszym projekcie warto policzyć wariant minimalny (agregacja na edge, krótsza retencja) i wariant „wszystko, co się da” – a potem świadomie wybrać kompromis.

Praktyczne wskazówki optymalizacji kosztów

Największy wpływ na koszt ma projekt protokołu i częstotliwość komunikacji, a dopiero potem wybór platformy.

- Agreguj dane na bramkach, szczególnie przy sensorach o wysokiej częstotliwości próbkowania.

- Komprimuj payload tam, gdzie to możliwe (proste kodowanie binarne zamiast JSON w częściach krytycznych).

- Rozdziel dane „operacyjne” (potrzebne na bieżąco) od surowych – pierwsze trzymaj w szybkich usługach, resztę archiwizuj w tańszym storage.

- Ustaw realne polityki retencji i lifecycle (S3 lifecycle, tiering w Azure Storage, retencja w bazach czasowych).

- Wykorzystaj darmowe pule i tańsze regiony, ale tylko jeśli nie kłóci się to z wymaganiami prawnymi i opóźnieniami.

Dobrym podejściem jest zbudowanie małego proof-of-concept z realnym ruchem, odczekanie kilku tygodni i przeanalizowanie rachunków. Dane z takiej próby są bardziej wiarygodne niż wyłącznie kalkulatory.

Narzędzia do prognozowania i kontroli kosztów

Obie chmury dostarczają kalkulatory i narzędzia do śledzenia wydatków.

- AWS: AWS Pricing Calculator, Cost Explorer, budżety (AWS Budgets) z alertami.

- Azure: Azure Pricing Calculator, Cost Management + Billing, alerty budżetowe.

W projektach IoT przydaje się tagowanie zasobów według projektu, środowiska i komponentu (edge, storage, analytics). Dzięki temu łatwiej wychwycić, czy przekroczenia biorą się z ruchu urządzeń, czy np. z nieoptymalnych zapytań analitycznych.

Przy dużych flotach rozsądne jest ustawienie progów alertów na poziomie dziennym, nie tylko miesięcznym. Nagły skok liczby komunikatów może oznaczać błąd w firmware lub atak.

Najważniejsze punkty

- Integracja IoT z chmurą ma sens przy rosnącej liczbie urządzeń, potrzebie globalnego dostępu do danych i długim cyklu życia systemu, bo eliminuje konieczność budowania własnej infrastruktury.

- Kluczowe scenariusze to monitoring ciągły, analityka i predykcja (ML/AI), zdalne sterowanie i aktualizacje OTA oraz raportowanie biznesowe oparte na danych z czujników połączonych z ERP/CRM/CMMS.

- Chmura (AWS IoT, Azure IoT) daje przewidywalne korzyści: skalowanie do tysięcy urządzeń, gotowe usługi analityczne i integracyjne, centralne bezpieczeństwo oraz szybsze wdrożenie dzięki gotowym komponentom.

- Architektura IoT bez chmury ma sens w środowiskach odciętych od Internetu, przy skrajnie niskich wymaganych opóźnieniach lub w bardzo małych, lokalnych wdrożeniach, gdzie publiczna chmura byłaby zbyt kosztowna i złożona.

- Przy wyborze między AWS IoT a Azure IoT kluczowe są: wymagane SLA i mechanizmy niezawodności, model kosztowy (wiadomości, transfer, przechowywanie, usługi dodatkowe), czas wdrożenia oraz dopasowanie do istniejącego ekosystemu IT.

- Typowa architektura IoT z chmurą opiera się na łańcuchu urządzenie → bramka edge → chmura IoT → usługi chmurowe → aplikacje biznesowe, co umożliwia centralne przetwarzanie danych i integrację z narzędziami analitycznymi.